De acuerdo con la Wikipedia, Big Data o Datos masivos es un concepto que hace referencia a la acumulación masiva de datos y a los procedimientos usados para identificar patrones recurrentes dentro de esos datos. También según la Wikipedia, la disciplina dedicada a los datos masivos se enmarca en el sector de las tecnologías de la información y la comunicación. Esta disciplina se ocupa de todas las actividades relacionadas con los sistemas que manipulan grandes conjuntos de datos. Las dificultades más habituales vinculadas a la gestión de estas cantidades de datos se centran en la captura, almacenamiento, búsqueda, compartición, análisis, y visualización.

Tal como afirma el diario ElEconomista.es en su artículo La moda del Big Data: ¿En qué consiste en realidad? escrito por José Carlos López López:

Big Data es uno de los conceptos de moda en el mundo informático (...). Sin embargo, observamos una gran confusión sobre "en qué consiste realmente". Empecemos entonces por tratar de aclarar "qué es Big Data".

Denominamos Big Data a la gestión y análisis de enormes volúmenes de datos que no pueden ser tratados de manera convencional, ya que superan los límites y capacidades de las herramientas de software habitualmente utilizadas para la captura, gestión y procesamiento de datos.

El problema viene de viejo, por lo menos desde 1880

Como vemos el término Big Data está de moda, sin embargo el problema de gestión de grandes volúmenes de datos es un problema al que se ha tenido que enfrentar la estadística pública desde hace muchos años. En ese sentido no es un problema nuevo, y el camino de la solución siempre ha sido tecnológico.

En 1880 comenzó a realizarse el censo en EEUU y debido a la cantidad de personas que lo formaba tardó 8 años en finalizarse, incluso habían variables que no se llegaron a tabular. Por este motivo, la US Census Bureau llevó a cabo un concurso en 1888 para encontrar un método más eficiente para procesar y tabular el gran volumen de datos que recopilaba. Se pidió a los concursantes que procesaran los datos del censo de 1880 de cuatro áreas en St Louis, MO, de tal manera que quien capturara y procesara los datos más rápido ganaría un contrato para el censo de 1890.

Tres concursantes aceptaron el reto de la US Census Bureau. Los dos primeros concursantes capturaron los datos en 144,5 horas y 100,5 horas respectivamente. El tercer contendiente, un exempleado de la US Census Bureau llamado Herman Hollerith, completó el proceso de captura de datos en 72,5 horas. A continuación, los participantes tuvieron que demostrar que sus diseños podrían preparar los datos para la tabulación (es decir tabular los datos por categorías de edades, razas, sexos, etc.). Dos de los concursantes necesitaron 44,5 horas y 55,5 horas respectivamente, en cambio Hollerith asombró a los funcionarios de la US Census Bureau al completar la tarea en tan sólo 5,5 horas.

Los impresionantes resultado de Herman Hollerith le supuso que el Gobierno de los Estados Unidos seleccionara su máquina tabuladora (considerada por algunos como la primera computadora) para elaborar el censo de 1890. Se tardaron sólo 3 años en perforar unos 56 millones de tarjetas. Esto permitió que el censo de ese país se realizara de una manera más fácil. Versiones modificadas de su tecnología se usaron en la oficina del censo americano hasta su sustitución por las computadoras en la década de 1950.

Herman Hollterith, las tarjetas perforadas e IBM

En 1885 Herman Hollerith construye la máquina censadora o tabuladora, que por medio de tarjetas perforadas reducía el tiempo de realización del censo.

En 1885 Herman Hollerith construye la máquina censadora o tabuladora, que por medio de tarjetas perforadas reducía el tiempo de realización del censo.

Herman Hollerith (1860-1929) trabajó brevemente para la US Census Bureau en el período previo al censo de 1880. Esta experiencia, junto con algunos consejos de mentor de John Shaw Billings, lo convenció de que la US Census Bureau necesitaba desesperadamente una alternativa al conteo manual para tabular los datos del censo. Hollerith fue capaz de inventar un dispositivo que hizo exactamente eso: una tabuladora eléctrica.

Herman Hollerith (1860-1929) trabajó brevemente para la US Census Bureau en el período previo al censo de 1880. Esta experiencia, junto con algunos consejos de mentor de John Shaw Billings, lo convenció de que la US Census Bureau necesitaba desesperadamente una alternativa al conteo manual para tabular los datos del censo. Hollerith fue capaz de inventar un dispositivo que hizo exactamente eso: una tabuladora eléctrica.

Hollerith observó que la mayor parte de las preguntas contenidas en los censos se podían contestar con un SÍ o un NO. Entonces ideó una tarjeta perforada, una cartulina en la que, según estuviera perforada o no en determinadas posiciones, se contestaba este tipo de preguntas. La tarjeta tenía 80 columnas. Hollerith patentó su máquina en 1889, un año después incluyó la operación de sumar con el fin de utilizarla en la contabilidad de los Ferrocarriles Centrales de Nueva York.

En 1896, Hollerith fundó la empresa Tabulating Machine Company, con el fin de explotar comercialmente su invento. En 1911, dicha compañía se fusionó con Computing Scale Company, International Time Recording Company y Bundy Manufacturing Company, para crear la Computing Tabulating Recording Corporation (CTR). El 14 de febrero de 1924, CTR cambió su nombre por el de International Business Machines Corporation (IBM).

El permanente problema de tabular un censo como motor de la tecnología de procesamiento de datos

A medida que la población de Estados Unidos crece, la US Census Bureau ha buscado continuamente estrategias para mejorar la velocidad y la precisión del proceso de levantamiento de censos. Cuando los Estados Unidos contaban con 3,9 millones de residentes en el primer censo en 1790, el gran volumen de trabajo de tabular a mano los resultado era uno de los mayores retos. A medida que el país creció, también lo hizo el desafío. Cuando contar los resultados del censo se hizo tan largo que casi duraba una década, la búsqueda de soluciones condujo necesariamente a la creación de la moderna tecnología de procesamiento de datos.

El primer dispositivo para acelerar el conteo del censo fue creado en 1872 por el Oficial Mayor del Censo Charles W. Seaton. La máquina utilizaba rodillos para sumar las pulsaciones de teclado introducidas manualmente. Sin embargo, incluso con la máquina Seaton el censo se llevó casi la década completa para su procesamiento.

El primer dispositivo para acelerar el conteo del censo fue creado en 1872 por el Oficial Mayor del Censo Charles W. Seaton. La máquina utilizaba rodillos para sumar las pulsaciones de teclado introducidas manualmente. Sin embargo, incluso con la máquina Seaton el censo se llevó casi la década completa para su procesamiento.

Tal como conté anteriormente en 1888 la US Census Bureau celebró un concurso para encontrar la manera más eficiente para procesar y tabular tdatos. El tabulador electrónico de Herman Hollerith resultó vencedor en la captura y procesamiento mediante la lectura de los agujeros en tarjetas perforadas. Con este tabulador los empleados del censo podían transferir la información de los cuestionarios censales a tarjetas perforadas, permitiendo la creación de cerca de 500 tarjetas perforadas al día.

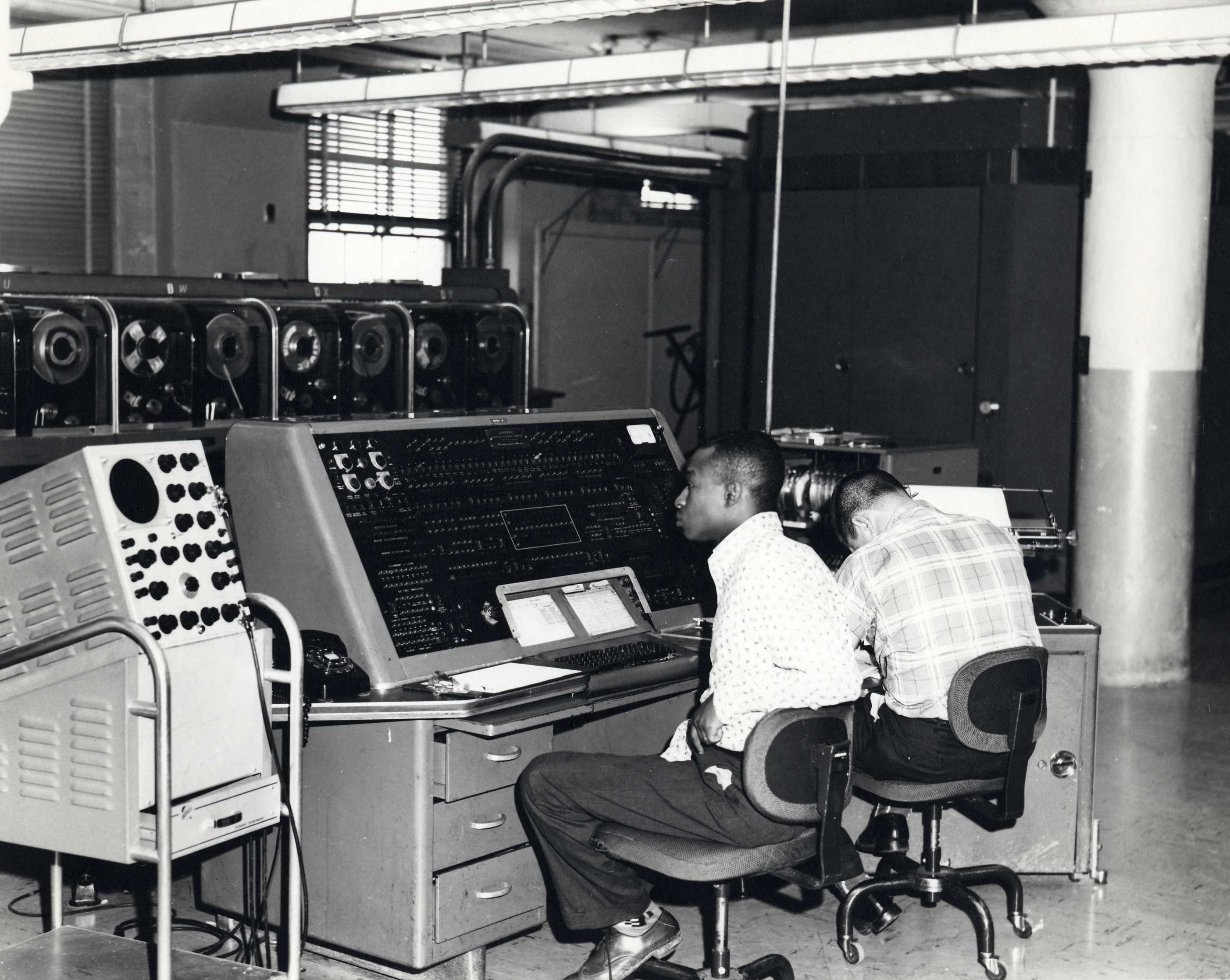

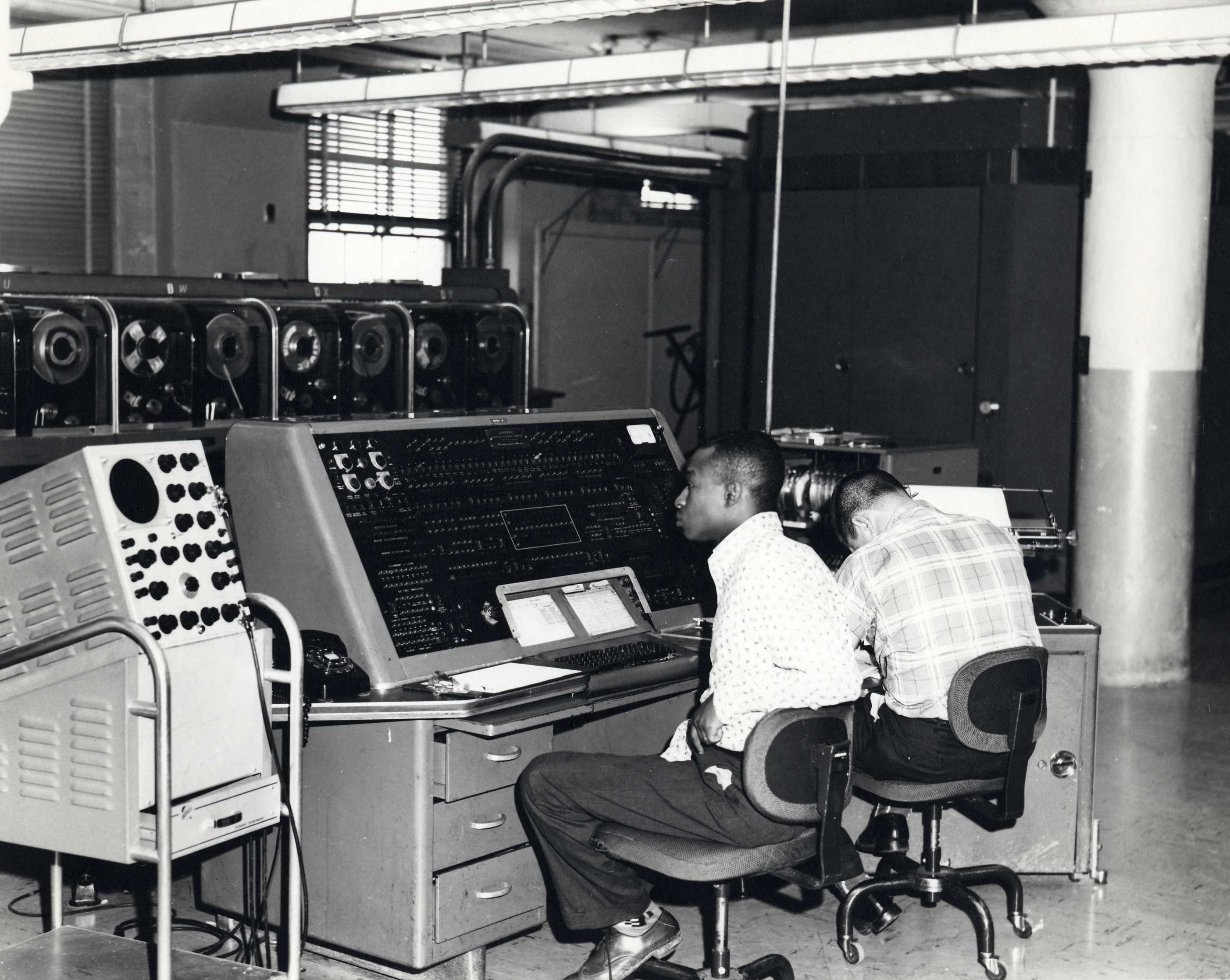

La oficina del censo de EEUU mantuvo la actualización y el uso de los tabuladores electrónicos de Hollerith hasta el censo de 1950, cuando fueron reemplazados por UNIVAC I, el primer ordenador moderno instalado por una agencia del gobierno civil. Por lo tanto la US Census Bureau se convirtió en el primer cliente de civil de la computadora digital moderna. Construido por la Eckert-Mauchley Computer Corporation a un costo de $400,000, UNIVAC procesaba los datos a un ritmo muy por delante de las antiguas máquinas de Hollerith, con datos introducidos con cinta magnética.

La oficina del censo de EEUU mantuvo la actualización y el uso de los tabuladores electrónicos de Hollerith hasta el censo de 1950, cuando fueron reemplazados por UNIVAC I, el primer ordenador moderno instalado por una agencia del gobierno civil. Por lo tanto la US Census Bureau se convirtió en el primer cliente de civil de la computadora digital moderna. Construido por la Eckert-Mauchley Computer Corporation a un costo de $400,000, UNIVAC procesaba los datos a un ritmo muy por delante de las antiguas máquinas de Hollerith, con datos introducidos con cinta magnética.

En la década de 1970, la agencia americana desarrolló los ficheros Dual Independent Map Encoding (DIME) y el sistema TIGER diseñado en la década de 1980 sentó las bases para la industria de sistema de información geográfica de hoy.

El permanente problema de tabular un censo como motor de la tecnología de procesamiento de datos

El primer dispositivo para acelerar el conteo del censo fue creado en 1872 por el Oficial Mayor del Censo Charles W. Seaton. La máquina utilizaba rodillos para sumar las pulsaciones de teclado introducidas manualmente. Sin embargo, incluso con la máquina Seaton el censo se llevó casi la década completa para su procesamiento.

El primer dispositivo para acelerar el conteo del censo fue creado en 1872 por el Oficial Mayor del Censo Charles W. Seaton. La máquina utilizaba rodillos para sumar las pulsaciones de teclado introducidas manualmente. Sin embargo, incluso con la máquina Seaton el censo se llevó casi la década completa para su procesamiento.Tal como conté anteriormente en 1888 la US Census Bureau celebró un concurso para encontrar la manera más eficiente para procesar y tabular tdatos. El tabulador electrónico de Herman Hollerith resultó vencedor en la captura y procesamiento mediante la lectura de los agujeros en tarjetas perforadas. Con este tabulador los empleados del censo podían transferir la información de los cuestionarios censales a tarjetas perforadas, permitiendo la creación de cerca de 500 tarjetas perforadas al día.

La oficina del censo de EEUU mantuvo la actualización y el uso de los tabuladores electrónicos de Hollerith hasta el censo de 1950, cuando fueron reemplazados por UNIVAC I, el primer ordenador moderno instalado por una agencia del gobierno civil. Por lo tanto la US Census Bureau se convirtió en el primer cliente de civil de la computadora digital moderna. Construido por la Eckert-Mauchley Computer Corporation a un costo de $400,000, UNIVAC procesaba los datos a un ritmo muy por delante de las antiguas máquinas de Hollerith, con datos introducidos con cinta magnética.

La oficina del censo de EEUU mantuvo la actualización y el uso de los tabuladores electrónicos de Hollerith hasta el censo de 1950, cuando fueron reemplazados por UNIVAC I, el primer ordenador moderno instalado por una agencia del gobierno civil. Por lo tanto la US Census Bureau se convirtió en el primer cliente de civil de la computadora digital moderna. Construido por la Eckert-Mauchley Computer Corporation a un costo de $400,000, UNIVAC procesaba los datos a un ritmo muy por delante de las antiguas máquinas de Hollerith, con datos introducidos con cinta magnética.En la década de 1970, la agencia americana desarrolló los ficheros Dual Independent Map Encoding (DIME) y el sistema TIGER diseñado en la década de 1980 sentó las bases para la industria de sistema de información geográfica de hoy.